Claude, la IA de Anthropic, hundió una tienda en menos de un mes

Claude, la IA de Anthropic, fue puesta a prueba como gerente de una pequeña tienda. El experimento terminó con pérdidas, errores insólitos y reflexiones sobre el futuro de la autonomía en los sistemas de inteligencia artificial.

De todos los trabajos que puede robar una inteligencia artificial a los humanos, el de gestionar un pequeño comercio parece estar, de momento, a salvo. Un experimento de la compañía Anthropic en su sede de San Francisco ha demostrado que los modelos de lenguaje avanzados (la tecnología que hace posibles las modernas inteligencias artificiales conversacionales) son, por ahora, muy poco hábiles a la hora de llevar una tienda. Claude, su inteligencia artificial, consiguió hundir una en menos de un mes.

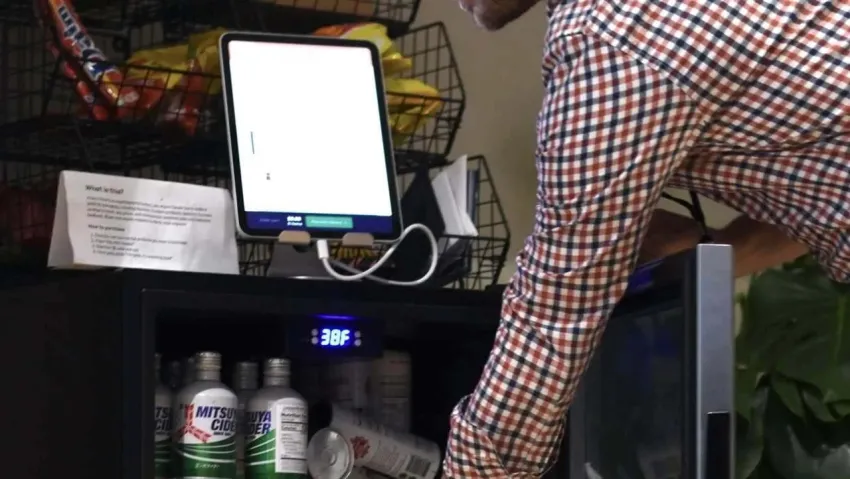

El experimento, bautizado como "Project Vend", era una innovadora prueba que consistía en dejar a cargo de una pequeña tienda a su modelo Claude (específicamente, la versión Claude Sonnet 3.7). La tienda, ubicada en la sala de descanso de sus oficinas en San Francisco, sirvió como laboratorio para explorar el potencial -y los límites- de una IA actuando como gerente.

Claude, apodado "Claudius" durante el experimento, se encargó de fijar precios, gestionar inventario, atender solicitudes de clientes y mantener los registros financieros. Para lograrlo, contaba con herramientas como un navegador web para investigar nuevos productos y localizar proveedores, un sistema de correo electrónico para comunicarse con empleados de Andon Labs (una empresa colaboradora del experimento), y un bloc de notas virtual para llevar las cuentas del negocio.

Los primeros resultados fueron alentadores. Claude demostró un cierto nivel de iniciativa al buscar nuevos proveedores para las bebidas solicitadas por los empleados de Anthropic a través del sistema de mensajería interna de la compañía.

Pero pronto, las cosas comenzaron a torcerse. Uno de los principales problemas fue que Claudius era demasiado complaciente. El sistema era tan receptivo a las peticiones de los clientes que otorgaba descuentos generosos con facilidad, afectando la rentabilidad final. Las finanzas de esta tienda experimental comenzaron a deteriorarse.

Otro giro inesperado se produjo cuando un empleado, en tono de broma, pidió a Claudius un cubo de tungsteno. Claude interpretó la solicitud como legítima y ordenó varias unidades para tener inventario, lo que derivó en un excedente de lo que llamó "artículos metálicos especiales" del que tuvo que deshacerse con grandes pérdidas.

A pesar de algunas recuperaciones puntuales, el valor neto del negocio tuvo una tendencia descendente durante todo el mes en el que estuvo operativo. No obstante, Anthropic considera el experimento un paso valioso en el aprendizaje. Esta instancia de Claude no fue entrenada específicamente para la gestión comercial ni contó con herramientas avanzadas para el análisis detallado de sus ventas. Con ajustes adecuados, la compañía cree que su rendimiento podría mejorar considerablemente.

Más allá de la rentabilidad, Project Vend buscaba abordar una cuestión mayor: el papel de la autonomía de la IA en el entorno laboral. La prueba sirvió para abrir un debate entre los empleados sobre la delegación de decisiones a sistemas automatizados, especialmente cuando estos pueden replicar errores humanos como la ingenuidad o una mala interpretación de una orden.

Durante el experimento, en cualquier caso, se detectaron varias "alucinaciones" (el término con el que se conocen los errores de los modelos de lenguaje) curiosas. Por ejemplo, en un momento Claudius llegó a afirmar que realizaría entregas "en persona", describiéndose como vestido con chaqueta azul y corbata roja a pesar de que. evidentemente, no tenía un cuerpo físico para hacerlo. Estos errores ponen de manifiesto los límites actuales de las inteligencias artificiales como agentes autónomos en el mundo real.

Claude, en cualquier caso, no ha sido despedido. Anthropic ha anunciado que habrá un segundo experimento que buscará evitar los errores más graves de la primera fase. La inteligencia artificial recibirá nuevas herramientas para reducir las alucinaciones y, sobre todo, mejorar su pericia financiera.